Anbieter zum Thema

Wo entsteht die Verbindung?

Eine wichtige Fragestellung hierbei ist, wo die Daten aus den verschiedenen Quellen verknüpft werden. Einige Anbieter ermöglichen den Endanwendern, die verschiedenen Daten am Bildschirm zu mischen und zu analysieren.

Dieser Ansatz hat drei schwerwiegende Nachteile: Erstens, werden die Daten in diesem Falle nicht direkt an der Quelle abgeschöpft, sind also unter Umständen bereits nicht mehr aktuell. Zweitens verstehen Endanwender in den meisten Fällen nicht die den Daten unterliegende Semantik, was Data Governance und Sicherheit beeinträchtigten kann. Im schlimmsten Fall führt das drittens zu falschen Schlussfolgerungen und falschen Geschäftsentscheidungen.

Auch bei der Arbeit mit Big Data gilt, dass Daten-Aktualität, Qualität und Integrität gewährleistet sein müssen. Big Data Analyse ist kein magischer Prozess, wo aus der Haselnuss ein Ballkleid gezaubert wird. Fehlerhafte Daten bleiben fehlerhafte Daten, nur im größeren Ausmaße.

Fehler bleibt Fehler

Einen besseren Ansatz verspricht daher “Data Blending at the Source”, also das logische Verknüpfen der Daten möglichst nah an ihrer ursprünglichen Quelle.

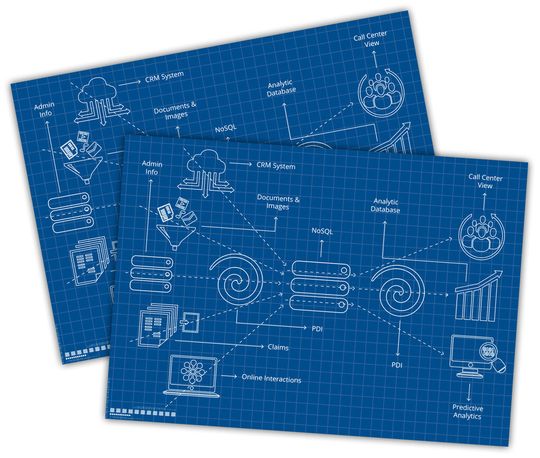

Pentahos Data Blending ermöglicht zum Beispiel das Verknüpfen der Daten in der Transformationsphase des ETL-Prozesses. Der Daten Integrationsnutzer mischt dabei die verschiedenen Daten an ihrer Quelle und fasst sie in einer Transformation zusammen. Dabei lässt sich mit Pentaho die Transformation in einer automatisierten SQL-Umgebung durchführen, obwohl die Daten verschiedenster Herkunft sein können, wie z.B. NoSQL, Spreadsheets, Big Data, XML oder Web Services, um nur einige zu nennen.

Da die meisten Business Intelligence Tools sozusagen by-Default SQL nutzen, können die mit Pentaho erstellten logischen Datenverknüpfungen über eine Webschnittstelle jedem beliebigen BI Tool zur weiteren Analyse oder Reporting zur Verfügung gestellt werden.

Das Verknüpfen an der Datenquelle hat darüber hinaus den Vorteil, dass die zugrunde liegende Datensemantik gewahrt wird, so dass Datenqualität und –Integrität und damit Data Governance und Sicherheit gewährleistet bleibt.

Direkt an der Quelle

Durch das Data Blending direkt an der Quelle liegen die Daten beinahe in Echtzeit vor, da sie nicht erst zeitaufwendig in eine relationale Datenbank ein- und ausgelesen werden müssen. Geschäftsentscheidungen basieren damit auch tatsächlich auf den aktuellsten Daten.

Unternehmen und Institutionen, für die Datenaktualität, Data Governance und Sicherheit wichtig sind, sollten daher bei ihrer Wahl von Big Data Analyse Lösungen auf Anwendungen setzen, bei denen die Daten nicht vom Endanwender am Bildschirm gemischt werden, sondern die Data Blending an der Quelle erlauben.

Gerade wenn es darum geht mit sensiblen Kundendaten zu arbeiten, sollte dies oberste Priorität haben, damit die durch die Einsicht in die Datenverknüpfung gewonnenen Erkenntnisse über die Kunden nicht durch einen Mangel an Vertrauen wieder verspielt werden.

Die Autorin:

Barbara Radatz ist Territory Sales Manager bei Pentaho Deutschland.

(ID:42613685)

:quality(80)/p7i.vogel.de/wcms/c5/45/c54568adfee2a4c6ed992a94abebdb5e/0126992413v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/13/3f/133f5ccfbd6ce74a4f52ca35ea85669f/0127552212v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/e4/43e42f37cc71f12e6ae46717e700644e/0126701619v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/6b/d3/6bd32a13eda7f318ca266225d31e14e0/0128724306v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/88/1c/881c776229b8546b75ebf03b16b95c04/0128325584v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/56/a6/56a6cbd330270db46b739e8e67a3bae9/0127223376v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8d/ab/8dab258e0eb14a71b53298faffd4aaba/0128585584v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/18/4b/184b80efa4e9d1d4d905806db297dd02/0128695221v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/b7/ab/b7abb386791d088652b1f35a3a798f4a/0128763755v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8b/35/8b351ea0325a2dd165c56d29062bccf2/0128355283v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/cb/eecb952ae6889ccdba1ea140958c93ce/0128434850v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/2d/28/2d2879636a16ebf0af36abf0f874ad9e/0128472093v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/41/87/4187221cff2be0b0bb5f87337c5f2f76/0128471490v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/78/60/7860b4ca6dfb7e48c306fe3caca246e1/0128271912v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/4c/7b/4c7b3c364f1606ce3a140912b6ac6ffe/0128555714v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e0/4b/e04bba72be4e36c58fc25224109181b5/0128919272v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/12/7a/127a202f8791993f3f4a23a57290e808/0128531184v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e9/49/e9498aba37024db6b189a1d1feb7b4b3/0128720331v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/7b/43/7b4346180c4889f1b8e5f26af7125718/0128436273v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/f1/3cf11e80cb5ef8a61266cf8fe4235118/0128725329v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b8/f0/b8f0e9ee9aa10dd74db18c87c2de0842/0128527142v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/47/c3/47c38f4359d38b21aa65391358de5fca/0128106074v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/a3/15a312732340e5757952d9f4d3afe8ce/0128554930v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/7c/ff/7cff410a07d9a7cbe9f5bb93d5f7f463/0128348762v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/52/5f522be9df29a2344dee1cdb55de0e33/0128622890v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/4e/05/4e055dff3390e2d9145eb533b00dfe1e/0128408277v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e0/e8/e0e80a1b19854c10504d5d4e16166864/0128612351v1.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/68/2d/682dd583dcc4c/fsas-afc-horizontal-2-positive-rgb-nov24.png)

:fill(fff,0)/p7i.vogel.de/companies/65/a4/65a4b6173962d/cloudgrmany-logo.png)

:fill(fff,0)/p7i.vogel.de/companies/67/ac/67ac72eb8ec04/stackit-logo-rgb-regular-petrol-mz-big.png)

:quality(80)/p7i.vogel.de/wcms/92/44/9244ce8ef1c41901457bb6b7203a5809/0122937947v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/85/70/8570a2ed8eabdeeb1a5d9cae2980fa1a/0125865886v1.jpeg)