Das Hadoop Öko-System

Um diese beiden Kern-Komponenten (Core Hadoop) herum tummelt sich ein ganzes Öko-Systems an weiteren Komponenten, wie die von Yahoo entwickelten Scripting Engine „Apache Pig“, „Apache Hive“, eine auf dem MapReduce-Framework basierende Abstraktionsebene mit einer SQL-ähnliche Abfragesprache „HiveQL“, Weiterhin sind „Hortonworks HCatalog“ für das Metadaten-Management oder die NoSQL-Datenbank „Apache HBase“ zu nennen, welche immer dann zum Einsatz kommt, wenn die Batch-orientierte Arbeitsweise von Hadoop mit ihrer Optimierung auf das einmalige Speichern und mehrmalige Lesen der Daten dem Problem nicht angemessen ist, etwa wenn ein Manipulieren der Daten gewünscht ist oder bei sehr schreib intensiven Szenarien.

Die SQL-ähnliche Abfragesprache HiveQL hingegen erlaubt das Ausführen von Abfragen oder ermöglicht Aggregationen und die Analyse der im HDFS gespeicherte Daten. Hive ist damit quasi die Data-Warehouse-Komponente des Hadoop-Frameworks.

Der Zoo

Hadoop kann inzwischen nicht nur relationale Datenbanken verwalten, sondern auch eine ganze Reihe von Spezial-Daten. So erlaubt etwa „Apache Flume“ das Sammeln und Aggregieren von Log-Daten.

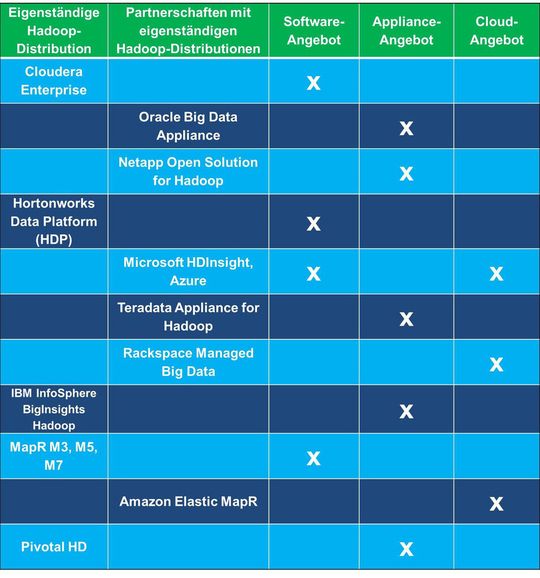

Die Hadoop-Distributionen

Während das Hadoop-Kernsystem (Core Hadoop) nur aus dem HDFS und MapReduce besteht, meint man mit Hadoop im allgemeinen Sprachgebrauch das oben skizzierte Ökosystem von verwandten, zusammenhängende, aufeinander basierenden Einzel-Projekten. Deshalb ist die Bezeichnung Hadoop-Framework sehr treffend.

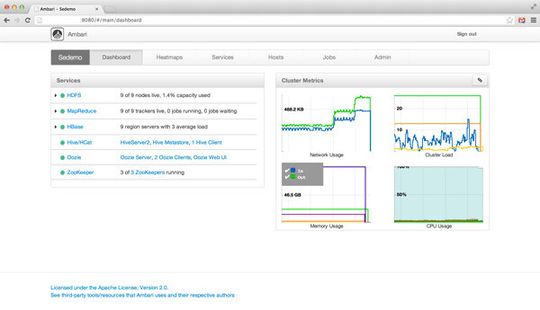

Das Installieren und Betreiben eines Hadoop-Cluster ist allerdings eine sehr komplexe Angelegenheit, weil Hadoop weder irgendeine Hilfe bei der Installation, noch bei der Überwachung eines Hadoop-Clusters bietet. Außerdem ist es sehr aufwendig, einzelnen Komponenten des geschilderten Hadoop-Öko-Systems zu nutzen oder in eigene Projekte zu integrieren, da jede davon einzeln installiert und konfiguriert werden muss.

Ferner sind nicht alle Komponenten miteinander kompatibel, so dass Unternehmen eine gehörige Portion Know How benötigen, um die jeweils zueinander passenden Versionen der jeweiligen Hadoop-Komponenten zu bestimmen und zur Zusammenarbeit zu bewegen. Hadoop pur eignet sich daher nur für hoch spezialisierte Fachleute oder Entwickler.

Hadoop-Distribution wie die oben genannten sind dagegen aufeinander abgestimmte Suiten aus der Hadoop-Basis-Software und weiteren Hadoop-Komponenten, zusätzlichen Tools und zum Teil herstellerspezifischen Erweiterungen. Eine Hadoop-Distribution lässt sich als integriertes Softwarepaket daher in der Regel einfacher konfigurieren und in Betrieb nehmen, als das quelloffene Hadoop-Core-System. Zudem bieten Hadoop-Distributionen den für viele Unternehmen unerlässlichen Hersteller-Support. Darüber hinaus gibt es noch die so genannten Big-Data-Suiten. Diese beruhen nur zum Teil auf Core-Hadoop, kombiniert mit eigenen Frameworks und enthalten im Gegensatz zu den Hadoop-Distributionen auch Werkzeuge für die Echtzeitanalyse, sowie Tools zur Datenmodellierung und Visualisierung.

Der Autor:

Thomas Driilling ist freier Autor und bloggt auf Datacenter-Insider: Drillings Open-Source-Eck

Artikelfiles und Artikellinks

(ID:42695649)

:quality(80)/p7i.vogel.de/wcms/c5/45/c54568adfee2a4c6ed992a94abebdb5e/0126992413v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/13/3f/133f5ccfbd6ce74a4f52ca35ea85669f/0127552212v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/e4/43e42f37cc71f12e6ae46717e700644e/0126701619v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/fa/7e/fa7e7df2fdbd8016ba198ac35232af27/0128893976v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/6b/d3/6bd32a13eda7f318ca266225d31e14e0/0128724306v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/88/1c/881c776229b8546b75ebf03b16b95c04/0128325584v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/8d/e0/8de00bb0c72231bc51fe6baa095aaf82/0128995925v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/06/a4/06a42876449bba06fb5efa3ecb9e189a/0129144465v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/71/977140cc64b447d359459de61d399935/0126773400v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/3b/9f3bdf09a933c60ea9852c1f83e87b5f/0129251655v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/17/40/1740df3260ea9ff0e7e9c8ad4b2b3011/0129143628v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/84/53/8453f71b2dfdcebe6bf23752fa99e5ae/0129219624v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0e/0a/0e0afeb87b4b85b5ae84a1ba995cee98/0128299374v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/bc/a5/bca56318391b40b360df5794c34cd81b/0129324079v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/34/fd/34fdef54803731e87c26c895abe5f9f0/0128873273v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/f9/7af9bb48ac1b02e6dd9f656a3764eafa/0129089298v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ba/f2/baf2bd1814e2831c86bf6ef4aec7296b/0129333921v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d2/38/d238c2fcfdd4a4e627c536e1fbce3796/0128962917v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/93/a3/93a3680c0c2d6e3482cc2db87242a999/0128746850v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/41/a8/41a80b82de1ca5fcade17371f7235e55/0128874597v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9a/29/9a29efcf7c1b664aafddddd07f7b0ef6/0127640958v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c5/dc/c5dc5a70b3b30c72d140b96c300743b7/0129090945v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9b/c4/9bc4fe1cc8c3e949b56c9ecd2fcd2c66/0129143613v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f8/15/f8156dc3222ebd6654313d107cc6c3eb/0128292755v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/aa/efaa0091321a96ccc000dbb5d90226f5/0124834701v1.jpeg)